华为云人工智能领域首席科学家、IEEE Fellow田奇博士

一是神经网络从小模型到大模型的趋势,过去十年,AI算法对算力的需求增长了40万倍。二是人工智能与科学计算的深度融合,在很多领域,包括工业、气象、能源、生物、医学等等,已经看到人工智能在对它们的深刻影响。我们认为像GPT-3这样的大模型,是解决AI应用碎片化的一种方式。大模型可以吸收海量的知识,从里面提高模型的泛化能力,可以减少对领域数据标注的依赖。以自然语言处理为例,这两年NLP预训模型取得突破式进展。从预训练模型的发展来看,从2017年的GPT 模型参数是1.1亿,到2018年BERT模型,它的参数达到了3.4亿,2020年1月份微软的Turing-NLG模型参数达到了170亿。不到半年的时间,在去年5月份发布的GPT-3参数量达到了1750亿,未来这个模型可能会达到万亿或更大。首先,大模型可能会收编高度定制化的小模型,使得行业和市场向大公司集中。这有两个原因:(1)资本的门槛高,在大模型的训练方面来讲成本很高,以GPT-3为例,训练一次成本是1200万美金;(2)技术门槛,在AI框架的深度优化和并行能力方面都有很高的要求,同时大模型也会改变AI发展的规则与格局,大模型可以牵引AI产业快速地收敛,成为AI产业的底座。同时在行业生态和开发生态来讲,可以形成产业生态的粘性。以NLP预训练大模型为例,过去10年NLP神经网络和网络计算参数量、模型参数量、计算复杂度已经增加了4-6个量级,从过去的10万级到现在的千亿级,过去单卡数天的训练到现在数千块卡数月的训练,语料库也从过去的百万级到现在的万亿级。华为云的AI计算平台 ModelArts 有其高效的模型并行与数据并行,可以支持超大规模的训练。比如512块GPU线性加速率可以达到90%以上,将来我们也会开发出业界领先的自然语言预训练模型。人工智能发展的另外一个趋势是:人工智能与科学计算的深度融合。人工智能取得的巨大成功,也为传统科学计算带来新的思路、方法和工具;同时传统科学计算由于其严密性,可以为人工智能提高其可解释性。人工智能和科学计算的融合结合可以在四个方面,分别为:模型、算法、软件、硬件。在模型方面,有AI建模,比如在分子力学中可以通过AI建模实现大规模分子模拟;在AI求解方面,比如在物理学中通过神经网络求解薛定谔方程,在电磁场仿真中用神经网络求解麦克斯韦方程,在生物学中通过AlphaFOLD2 的算法实现了蛋白质结构预测;

除了模型和算法,还包括软件层面,比如软件的编译调优、自动代码生成,AI都可以做出自己的贡献。最后人工智能对硬件的设计已经有了深刻的影响,包括计算单元的设计、芯片设计、处理器的设计以及超算系统设计。以电磁场仿真为例,智能终端手机或者耳机天线需要大量的电磁场仿真,每年我们对电磁场仿真的调用次数大概在1万次左右,而每个仿真的核心是求解一个麦克斯韦思维方程。由于手机的边界条件复杂,因此传统方法求解麦克斯韦方程非常慢,非常复杂,而且并行度难度比较低,因此每次电磁场仿真需要10个小时,每年可能需要10万个GPU小时。通过神经网络求解,在达到传统算法相同或者近似精度情况下可以让求解效率大幅提升,可以提升70-90%,这样每年可以节约7-10万个GPU小时。接下来给大家介绍一下华为在通用AI技术的基础研究情况,前面提到为了解决AI应用碎片化的问题,我们致力于打造通用的AI系统,主要有几个特性,一个是通用性:跨场景覆盖能力,另外是小样板学习能力,泛化能力强,当然包括卓越性能。为了打造更好的通用AI系统,我们以计算机视觉预训练大模型为例,介绍一下我们研究的进展。视觉预训练大模型简称视觉大模型,主要包括两个方面:数据高效和模型高效,数据高效指的是如何从海量数据中去吸收挖掘有效视觉信息,模型高效就是如何设计高效的神经网络,在大模型中模型高效和数据高效都是为了后面预训练模型中的知识抽取服务。

第一个方向,数据高效,海量数据中怎样挖掘有效视觉信息。这里主要聚焦于在自监督预训练任务中学习知识。大家知道在计算机视觉中学习如何迁移到不同任务的泛化特征是CV的一个基本技术,过去泛化特征是靠监督学习得到,这几年自监督学习由于不需要标注的数据就能学到图像内在的表征,引起业界极大的关注。自监督学习通过一系列预先设定任务(spantext task)作为自动生成监督信号来指导模型训练,再把训练模型迁移到下游任务中。这里主流预训练任务主要包括两种,一种是生成式,一种对比式。生成式任务以自编码为例,主要是通过自编码恢复图像或局部的特征。另外自监督学习这一年取得极大进展,像谷歌的SimCLR,以及Facebook的MoCo都是基于实例区分的对比自监督学习。目前自监督预训练模型处于百花齐放方兴未艾的状态。视觉预训练模型成为CV领域知识抽取的高效方式,自监督学习在最近几年也取得了极大进展。以这张图为例,上面的绿线代表的是ImageNet线性分类精度,这条红线代表的是基于ResNet-50的监督学习Top1精度,大概76.5%左右。这条蓝线是这几年对比自监督学习进展情况,可以看到取得了一个极大的进展,尤其是去年MoCo、SimCLR、BYOL几个模型。

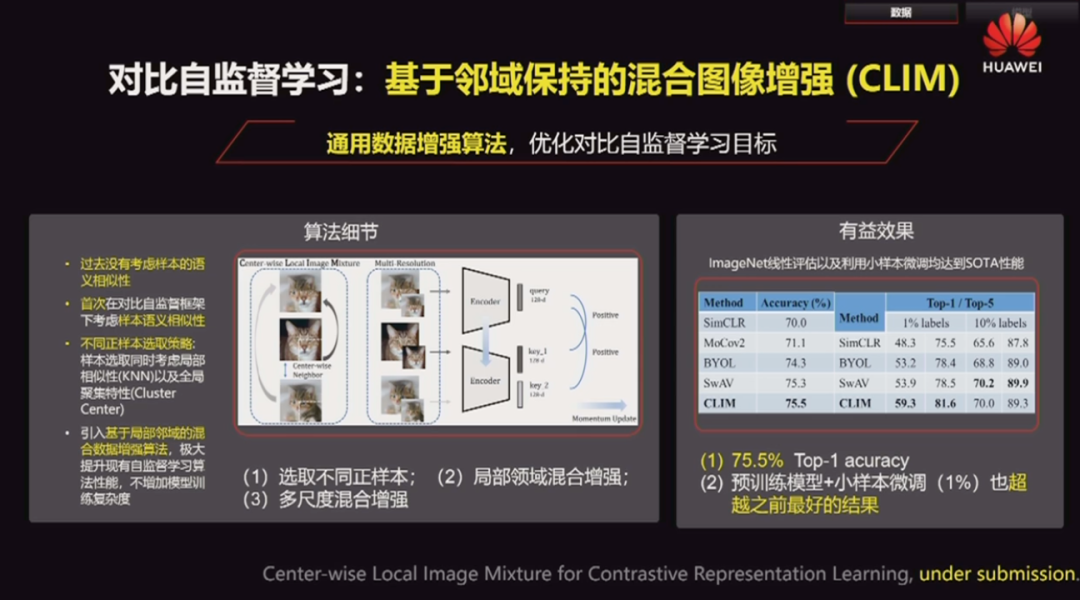

在这基础上,我们自研的自监督学习方法包括HSA、CLIM、SCAN等等,基本上通过自监督学习达到了全监督学习基线的水准。简单介绍其中工作,第一个工作是基于对比自监督学习的方法,我们提出了一个基于邻域保持的混合图像增强的办法叫CLIM,这个方法的核心思想比较简单,过去每一个样本都会当成一个独立的类别,并没有考虑不同样本的语义相似性。在这里,我们首次在对比自监督框架下考虑样本语义相似性,提出了不同正样本选取的策略,以及关于推荐出来的正样本进入局部邻域混合增强和多尺度增强的思路。从结果上来看,Top1 accuracy在ImageNet上达到了75.5%,在下游任务中微调模型,这里用1%的数据也超越了之前最好的效果。

在这个工作之后,我们又提出了另外一种基于等级化语义聚集的对比自监督学习的框架,主要核心点通过等级化语义聚集拓展了正样本数量,同时除了在高层特征的对比自监督学习,我们也在浅层特征上做了对比自监督学习,从结果来看Top1 accuracy 达到了76.4%,基本上达到全监督学习的基线,而且在下游预训练+小样本微调也达到了新的SOTA结果。第三个工作,提出一种基于标签高效利用的视觉预训练方法,叫SCAN,核心是对比自监督学习过程中引入了图像增值标签,选择正样本同时选择语义相同的标签,和外观相似(通过KNN的办法)挑选正样本进行对比学习,极大提高了模型的泛化能力,在检测、分割、实例分割等各个下游任务上全面超越了以往自监督和全监督的泛化能力。下面是模型高效,模型高效就是如何设计高效的视觉模型。涉及到如何设计更好的网络模型,包括如何设计神经网络,如何在语言子集上进行网络架构的搜索。最早神经网络都是手工设计的,从AlexNet,VGGNet,ResNet再到MobileNet,经过快速发展也进入了瓶颈期,因此业界从2017年开始自动网络架构搜索进入一个蓬勃发展的阶段,也出现了很多新的工作。但自动网络架构搜索(NAS)能够真的代替手工设计的网络吗?同时也面临几个问题。第一,搜索空间需要人工经验来定义,第二,待搜算子需要手工设计,第三,搜索到的网络较手工设计网络迁移性比较差。

第一个工作P-DARTS,提出一种渐进可微分网络架构搜索算法,这里在传统神经网络架构搜索中主要存在搜索网络和测试网络深度差异问题,搜索网络较浅,测试网络较深,因此在较浅搜索网络上,搜索得到的网络,在较深的测试网络上它的匹配效果并不是很好。

而为了解决这个问题,如果直接加深搜索的深度会导致显存的爆炸,同时在较深网络中进行搜索也会导致搜索的不稳定性,为了解决这个问题我们提出了「渐进搜索+搜索空间近似+搜索空间正则」的思路。渐进搜索方法,从5层到11层再到17层,同时在搜索过程中提出了减少搜索空间近似的办法,如何做空间正则减少来提高系统稳定性。从结果来看在CIFAR 10 上搜索网络迁移到ImageNet上的分类精度比以前基线平均提高了两个百分点,从性能和效率来看与前一年谷歌NASNet相比搜索效率从几千个GPU-days 降到7个小时,与同时代DARTS方法相比性能和搜索速度都有超越。下面是神经网络架构搜索另外一个工作,叫PC-DARTS。提出一种部分连接可微分网络架构搜索算法。这是业界目前搜索速度最快的NAS方法之一,要解决的问题也是解决网络冗余问题和网络搜索不稳定的问题。为了解决网络冗余问题我们提出了一种部分连接的思路,减少网络冗余。为了提高网络搜索稳定性,我们提出了边正则化的方法,从结果上来看这是DARTS系列方法首次完成在ImageNet上的搜索,与以前方法相比不仅性能有所提高,而且搜索速度快了近一倍。